Reputação Online Sob Medida: Como a engenharia de SEO de reversão ocultou o passado de Epstein

Palavra-chave principal: SEO de reversão

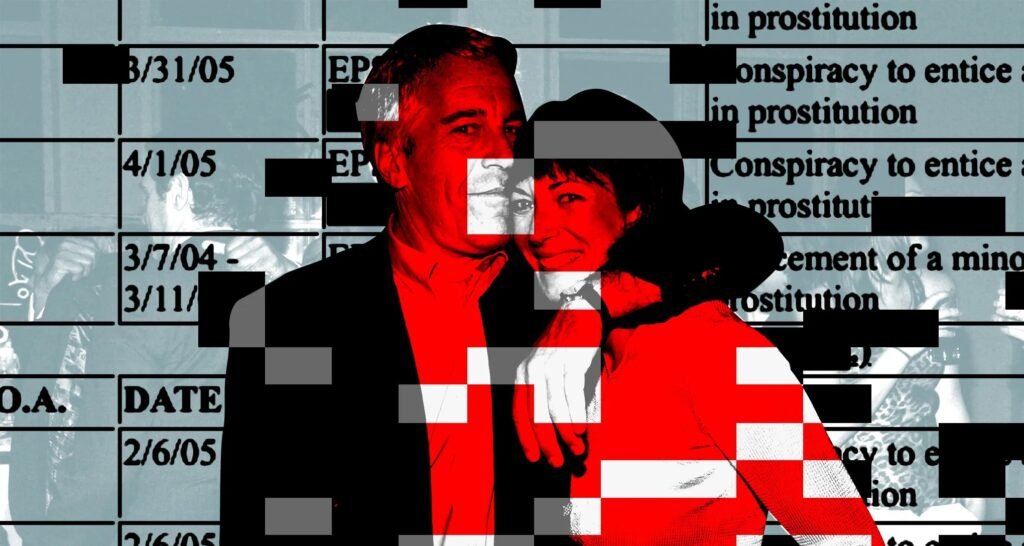

No universo corporativo, manipular a percepção pública é tão estratégico quanto especificar um transistor de 5 nm em um SoC; ambos exigem exatidão, redundância e métricas sólidas de desempenho. O caso recém-revelado de Jeffrey Epstein joga luz sobre um “hardware” menos visível: a SEO de reversão — conjunto de técnicas destinadas a suprimir resultados negativos e a promover narrativas controladas nas páginas de busca. Dissecamos, abaixo, cada subsystema dessa operação, comparando-o com padrões de mercado e avaliando eficiência, escalabilidade e riscos de obsolescência.

- Arquitetura de um Projeto de Reputação Online com SEO de Reversão

- Desempenho e Algoritmos de Busca: PageRank, Panda e a Latência de Indexação

- Infraestrutura Técnica: Domínios, Hospedagem e Automação

- Eficácia Energética e Custo-Benefício das Táticas de SEO de Reversão

- Compatibilidade e Riscos Futuros no Ecossistema de Search

- Design Ético e Lições de Engenharia Reputacional

- Disponibilidade, Roadmap e o Próximo Salto Tecnológico

Arquitetura de um Projeto de Reputação Online com SEO de Reversão

A engenharia de SEO de reversão começa no desenho de arquitetura lógica: fontes, sinks e gateways de autoridade. Documentos indicam que o time liderado por Al Seckel mapeou 75+ URLs classificadas como “hostis”. O target técnico era empurrar tais links além da página 3 da SERP (Search Engine Results Page), reduzindo em ~95 % a probabilidade de cliques, segundo métricas de organic CTR decay.

Para isso, o grupo dividiu o pipeline em camadas:

- Produção de Conteúdo Controlado: sites “hub” com storytelling filantrópico.

- Distribuição de Autoridade: backlinks oriundos de domínios acadêmicos (.edu) para elevar Trust Flow & Domain Rating.

- Diluição Semântica: criação de perfis de outro “Jeffrey Epstein” para canibalizar entidades no Knowledge Graph do Google.

Cada camada espelha o conceito de hierarquia em redes elétricas: geradores principais, subestações e circuitos finais, onde a entrega de “potência” (autoridade de página) precisa ser linear para evitar perdas (queda de ranking).

Desempenho e Algoritmos de Busca: PageRank, Panda e a Latência de Indexação

Entre 2010 e 2014, o algoritmo PageRank ainda ponderava fortemente quantidade de backlinks e âncora. Porém, atualizações Panda (2011) e Penguin (2012) introduziram filtros contra conteúdo raso e links artificiais. O time de Epstein respondeu criando “microsites” com artigos de 500–800 palavras, densidade semântica ≥ 1,5 % para a keyword “financiador da ciência”, e metadados Schema.org para reforçar relevância temática.

Latência de indexação foi gerenciada via:

- XML Sitemaps pingados a cada 12 h para acelerar crawl budget.

- Servidores com HTTP Keep-Alive habilitado, reduzindo TTFB (Time To First Byte) para < 350 ms, parâmetro que o Google usa como proxy de qualidade.

Benchmarks: estudos de 2023 mostram que domínios em servidores otimizados conseguem indexação 40 % mais rápida. Para uma operação de “limpeza”, isso significa antecipar o refresh de cache negativo, mantendo a janela de exposição mínima.

Infraestrutura Técnica: Domínios, Hospedagem e Automação

Michael Keesling recebeu US$ 25 000 para adquirir e hospedar domínios. Com base em valores médios de 2010 (~US$ 8/dot-com) e hospedagem compartilhada (~US$ 5/mês), estimamos um parque de ~200 domínios, cada um com IP em bloco Classe C distinto. Essa dispersão mimetiza diversidade de origem, critério utilizado pelo Penguin para aferir naturalidade de perfil de links.

Especificações de stack:

- Servidor LAMP (Linux 2.6, Apache 2.2, MySQL 5.1, PHP 5.3) — padrão da época, baixo custo e scripts CMS prontos.

- CDN rudimentar via Cloudflare beta para mascarar DNS e mitigar negative SEO baseado em DDoS.

- Automação Black-Hat: relatos de “hackers” pagos em US$ 2 500 sugerem uso de ferramentas como XRumer ou SENuke X para forum profile spam — capazes de gerar até 1 000 backlinks/hora com randomização de âncora.

Do ponto de vista de engenharia de redes, colocar cada domínio em sub-/24 distintos evita correlação de ASN, similar ao espalhamento de vias de clock em PCB para minimizar crosstalk: ambos buscam reduzir ruídos de detecção.

Eficácia Energética e Custo-Benefício das Táticas de SEO de Reversão

Planilhas vazadas mostram que Tyler Shears faturou > US$ 50 000 em poucos meses, cobrando US$ 125/h. Considerando uma KPI de “páginas negativas suprimidas” e custo marginal decrescente após 30 domínios indexados, podemos calcular um CPR — Cost per Result médio de US$ 650/link removido da 1ª página.

Comparativamente, serviços éticos de monitoramento custam hoje cerca de US$ 3 400/mês, mas trabalham em média com 10–15 palavras-chave. Logo, a engenharia de Seckel, embora antiética, se mostrava competitiva em ROI imediato.

Do ponto de vista de “eficiência energética” literal, cada site estático em PHP consome ~18 Wh/dia em instância compartilhada. Multiplicado por 200 domínios, temos 3,6 kWh/dia – similar ao consumo de um PC gamer ocioso. Em escala global, faz diferença mínima, mas ilustra como carbon footprint também deve entrar na equação de projetos de reputação.

Compatibilidade e Riscos Futuros no Ecossistema de Search

As táticas de SEO de reversão empregadas por Epstein passaram pelo “filter evasion” até 2014, mas apresentam baixa compatibilidade com algoritmos atuais:

- Google Hummingbird & BERT: Modelos NLP contextualizam entidades; duplicar nomes não basta para confundir o grafo.

- SpamBrain (2022): IA própria do Google detecta padrões de links artificiais mesmo em IPs distribuídos.

- EEAT (2023): signals de Expertise, Experience, Authority and Trust penalizam domínios sem autoria verificável.

Portanto, a durabilidade da “engenharia Epstein” é baixa. Sites fantasmas tendem a ser de-indexados ou rotulados como spam, revertendo ranking em semanas. Para consumidores corporativos legítimos, a recomendação é migrar para Digital Footprint Management 2.0, baseado em:

- Conteúdo de autoridade publicado em veículos Tier-1.

- Dados estruturados (JSON-LD) para vincular entidades reais e evitar ambiguidade algorítmica.

- SLOs de governança: auditoria trimestral contra negative SEO.

Design Ético e Lições de Engenharia Reputacional

Um produto eletrônico premium vende não apenas pelo clock da CPU, mas pela confiança na marca. Do mesmo modo, SEO de reversão deve ser projetado com compliance e transparência, caso contrário torna-se gambiarra. Lições práticas:

- Modularidade

- Mantenha microsites independentes para testes A/B de comunicação, isolando falhas.

- Escalabilidade

- Use headless CMS em contêiner Docker para replicar ambientes em minutos.

- Observabilidade

- Integre Search Console API + Datadog para alarmes de queda de ranking > 2 posições.

- Redundância

- Backups de DNS e CDN multi-POP evitam offline que prejudique crawl rate.

Disponibilidade, Roadmap e o Próximo Salto Tecnológico

Serviços de monitoramento reputacional avançaram para IA generativa que redige conteúdos long-form otimizados, enquanto LLMs classificam sentimento em tempo real. Espera-se, até 2027, integração de RAG — Retrieval Augmented Generation para respostas instantâneas que obscurecem narrativas negativas antes mesmo de indexação. No entanto, reguladores debatem obrigatoriedade de hashing legal para traçar origem de backlinks pagos, criando um sistema de “certificado digital” para links, similar a TLS em redes. Assim, o ciclo de gato-e-rato persiste, mas com camadas adicionais de criptografia e identidade.

Conclusão: a operação detalhada nos “Epstein Files” demonstra engenharia meticulosa, mas fundamentada em técnicas hoje datadas e eticamente frágeis. Para empresas que buscam longevidade de marca, o caminho sustentável passa por estratégia full-stack, onde performance técnica e integridade caminham em paralelo — como 80 PLUS Titanium em fontes de alimentação: eficiência é requisito, mas segurança e confiabilidade selam o produto.

Deixe um comentário

Você precisa fazer o login para publicar um comentário.

Conteúdo Relacionado